特大型互聯網站應對海量數據的常見策略 構建高效、可靠的數據服務基石

在當今數字化時代,特大型互聯網站(如電商平臺、社交媒體、搜索引擎、流媒體服務等)每日需處理PB乃至EB級別的海量數據。這些數據不僅包括用戶的每一次點擊、搜索、交易、社交互動,還涵蓋了系統日志、機器生成的事件流等。如何高效、可靠地存儲、處理、分析和利用這些數據,直接關系到網站的可用性、用戶體驗與商業智能。以下是解決海量數據挑戰的幾大核心策略,共同構成了現代互聯網數據服務的基石。

1. 分布式系統架構:化整為零的核心

處理海量數據的首要原則是摒棄單一、集中的系統,采用分布式架構。

- 分布式存儲: 使用如HDFS、Amazon S3、Google Cloud Storage等對象存儲,或分布式數據庫(如NoSQL數據庫Cassandra、HBase,NewSQL數據庫Spanner、TiDB),將數據分片(Sharding)存儲于成百上千臺服務器上,實現存儲容量的水平擴展。

- 分布式計算: 利用MapReduce、Spark、Flink等計算框架,將大規模計算任務分解成無數小任務,分配到集群中的各個節點并行處理,最后匯果,極大提升了數據處理速度。

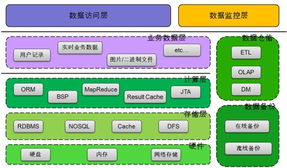

2. 數據庫選型與分層:因“數據”制宜

沒有一種數據庫能解決所有問題,因此常采用多類型數據庫組合的策略。

- 在線交易處理(OLTP): 處理高并發、低延遲的實時讀寫請求,如用戶下單、支付。常選用關系型數據庫(如MySQL、PostgreSQL,通常進行分庫分表),或具備強一致性的NoSQL數據庫。

- 在線分析處理(OLAP): 用于復雜查詢與數據分析,支撐商業決策。通常使用列式存儲數據庫(如ClickHouse、Apache Druid)或大數據查詢引擎(如Presto、Hive),它們對海量數據的聚合分析有顯著優勢。

- 緩存層: 在數據庫前加入Redis、Memcached等內存數據庫,緩存熱點數據,將讀請求壓力從主數據庫分流,響應時間可降至毫秒甚至微秒級。

3. 數據管道與流批一體:讓數據流動起來

海量數據需要被高效地采集、傳輸和處理。

- 批處理: 適用于對時效性要求不高的海量歷史數據計算,如日終報表。Apache Hadoop是其經典代表。

- 流處理: 針對實時產生的數據流進行即時處理,如實時監控、推薦系統更新。常用Kafka作為高吞吐的消息隊列,配合Storm、Flink、Spark Streaming進行計算。

- Lambda/Kappa架構: 為了兼顧批處理的準確性與流處理的實時性,出現了Lambda架構(批處理層+速度層)及其簡化版Kappa架構(全流處理)。目前,流批一體(如Apache Flink)正成為趨勢,試圖用一套框架統一處理兩種場景。

4. 彈性計算與云原生:按需伸縮

面對流量的不確定性和數據的快速增長,彈性伸縮能力至關重要。

- 容器化與編排: 使用Docker容器封裝應用,通過Kubernetes等平臺進行編排管理,可以實現計算資源的快速部署、擴展和收縮。

- 無服務器計算: 在數據處理特定環節(如事件觸發、數據轉換)采用AWS Lambda、Google Cloud Functions等服務,完全按實際使用量計費,無需管理服務器。

- 混合云與多云策略: 利用公有云的無限擴展能力處理峰值負載,同時可能保留私有云以控制核心數據,實現成本、性能與安全的平衡。

5. 數據壓縮與編碼:節省存儲與帶寬

原始數據往往非常龐大,高效的壓縮(如Snappy、Zstandard、LZ4)和列式存儲編碼(如Google的RLE、Dictionary Encoding)能在不明顯影響性能的前提下,大幅減少存儲空間和網絡傳輸開銷。

6. 監控、治理與成本優化:可持續發展的保障

管理海量數據不僅是技術問題,更是運營和治理問題。

- 全鏈路監控: 對數據采集、傳輸、計算、存儲的每一個環節進行細粒度監控(使用Prometheus、Grafana等工具),確保數據服務的SLA(服務等級協議)。

- 數據治理: 建立數據血緣、元數據管理、數據質量檢測體系,確保數據的準確性、一致性和安全性,符合法規要求。

- 成本控制: 通過數據生命周期管理(自動將冷數據移至廉價存儲)、資源調度優化、計算任務調優等手段,在性能與成本間找到最佳平衡點。

###

特大型互聯網站的海量數據服務,已從單一的技術棧演變為一個融合了分布式計算、多種數據庫技術、實時流處理、云原生架構及精細化運營的復雜生態系統。其核心思想始終是分而治之、并行處理、按需伸縮、持續優化。隨著人工智能和機器學習對數據需求的進一步加深,這一領域的策略與技術將持續演進,以挖掘數據洪流中蘊藏的巨大價值。在更智能的自動化數據管理、更統一的處理框架以及更強的實時能力,將是發展的主要方向。

如若轉載,請注明出處:http://www.hanfengo2o.cn/product/37.html

更新時間:2026-01-10 01:23:16