扣丁學堂大數據在線學習 淺談Hadoop在互聯網數據服務中的生命周期

隨著互聯網技術的飛速發展,大數據已成為企業和組織決策的重要支撐。Hadoop作為大數據處理的核心框架之一,自誕生以來在數據存儲、計算和分析領域發揮了關鍵作用。本文將從Hadoop的技術演進、當前應用現狀以及未來前景,探討其在互聯網數據服務中的生命周期。

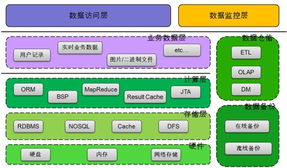

Hadoop的生命周期可以追溯到2006年,由Apache軟件基金會推出,它基于Google的MapReduce和GFS論文設計,旨在解決海量數據的分布式處理問題。在早期階段,Hadoop憑借其高容錯性和可擴展性,迅速成為企業大數據平臺的首選,廣泛應用于日志分析、用戶行為追蹤等互聯網數據服務場景。這一時期,Hadoop的生命周期處于快速增長期,許多公司如Yahoo、Facebook等大規模部署Hadoop集群,推動了其生態系統的完善,包括HDFS、MapReduce、Hive和HBase等組件。

隨著技術環境的變遷,Hadoop的生命周期也面臨挑戰。云計算、容器化和實時處理技術的興起,使得一些新興框架如Spark、Flink等在特定場景下表現更優,導致Hadoop在某些互聯網數據服務中的使用率有所下降。例如,Spark的內存計算能力在處理迭代算法和流數據時效率更高,而云服務商提供的托管解決方案減少了對自建Hadoop集群的依賴。這表明Hadoop的生命周期可能已進入成熟期或調整期,但其核心組件如HDFS仍然在許多混合云和多云環境中作為數據湖的基礎存儲層。

從長遠來看,Hadoop的生命周期并未終結。在互聯網數據服務中,Hadoop依然在批處理、歷史數據分析和成本敏感型應用中占據重要地位。許多企業通過集成Hadoop與新興技術,實現混合架構,以平衡性能與成本。Hadoop生態系統不斷進化,例如通過YARN資源管理支持多種計算框架,延長了其生命周期。預計在未來5-10年內,Hadoop仍將作為大數據基礎設施的一部分,服務于互聯網數據存儲、ETL流程和機器學習管道。

Hadoop的生命周期在互聯網數據服務中經歷了從興起、成熟到轉型的過程。盡管面臨競爭,但其可靠性、社區支持和成本效益確保了其在特定應用中的持久性。對于學習者而言,通過扣丁學堂等在線平臺掌握Hadoop技術,不僅能理解大數據基礎,還能為應對未來技術演變做好準備。Hadoop的生命周期長短取決于企業如何將其與創新技術結合,以適應快速變化的互聯網數據需求。

如若轉載,請注明出處:http://www.hanfengo2o.cn/product/25.html

更新時間:2026-01-12 18:57:38